iOS

Apple เตรียมเปิดตัวฟีเจอร์สแกนภาพและวีดีโอล่วงละเมิดทางเพศเด็ก

Apple เผยถึงฟีเจอร์ที่กำลังจะมาในอนาคตบน iOS 15, iPadOS 15 และ macOS Montery ที่จะช่วยปกป้องเด็กๆจากสื่อลากมกอนาจารทั้งหลาย

By

Apple เผยถึงฟีเจอร์ที่กำลังจะมาในอนาคตบน iOS 15, iPadOS 15 และ macOS Montery ที่จะช่วยปกป้องเด็กๆจากสื่อลากมกอนาจารทั้งหลาย

โดยฟีเจอร์นี้แม้จะมีความทะเยอทะยานอย่างมากแต่การปกป้องสิทธิของเด็กๆก็เป็นเรื่องสำคัญเช่นกัน โดย Apple กล่าวว่าได้ทำงานร่วมกับผู้เชี่ยวชาวด้านความปลอดภัยของเด็กเพื่อพัฒนาคุณสมบัติใหม่ๆด้านความปลอดภัยสำหรับเด็กใน 3 ด้านดังนี้

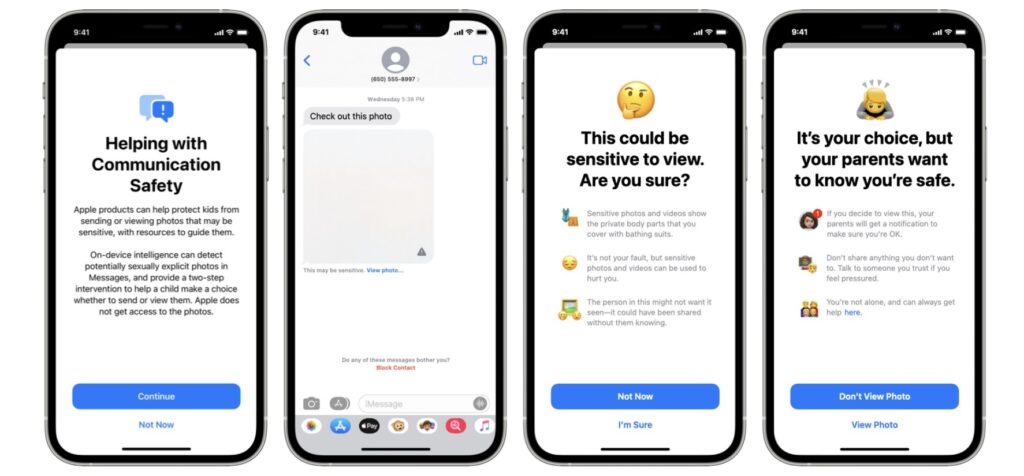

กรองเนื้อหาอนาจารผ่านแอป Message

แอป Message จะเพิ่มเครื่องมือใหม่ในการเตือนเด็กๆและผู้ปกครองเมื่อรับหรือส่งรูปภาพอนาจารต่างๆ โดยจะมีการเบลอภาพหากมีคนส่งภาพอนาจรต่างๆมาให้กับเด็กพร้อมข้อความแจ้งเตือน และเมื่อเด็กๆจะส่งรูปภาพอนาจารไปให้คนอื่นๆมันก็จะมีการเตือนเด็กๆกันก่อนที่จะทำการส่ง

โดยระบบนี้จะแบ่งเด็กออกเป็น 2 ประเภทคือ เด็กที่อายุอายุต่ำกว่า 13 ปี และอายุระหว่าง 13 ถึง 17 ปี

- สำหรับเด็กที่อายุต่ำกว่า 13 ปี หากได้รับภาพและเลือกที่จะกดดูหรือต้องการจะส่งภาพอนาจารออกไป ก็จะได้รับการแจ้งเตือนว่าหากเลือกที่จะดูหรือส่งออกไป จะมีการแจ้งเตือนไปหาผู้ปกครองว่าเด็กๆได้มีการกระทำดังกล่าว

- ในส่วนของเด็กอายุ 13 ถึง 17 ปีนั้น จะได้รับเพียงข้อความเตือนก่อนที่จะดูหรือส่งรูปอนาจารเท่านั้น จะไม่มีการแจ้งเตือนไปยังผู้ปกครองของเด็กๆเหล่านั้น

Apple กล่าวว่าฟีเจอร์นี้จะทำงานผ่าน AI บนอุปกรณ์เพื่อสแกนหารูปที่เข้าข่ายอนาจารเพื่อป้องกันไม่ให้ Apple สามารถเข้าถึงข้อความได้

อย่างไรก็ตามฟีเจอร์นี้จะใช้งานได้กับแอป Message เท่านั้นแอปอื่นๆอย่าง Line หรือ Messenger จะไม่สามารถใช้ได้

CSMA

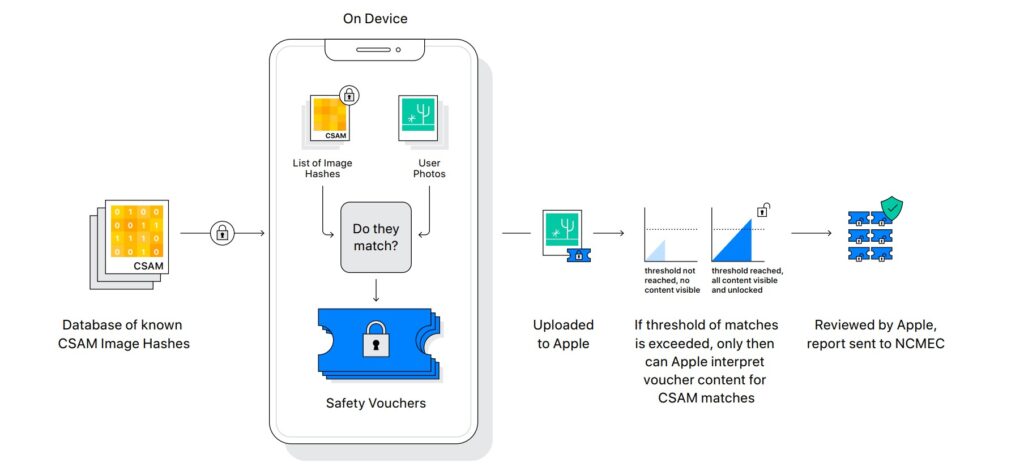

อีกสิ่งหนึ่งที่ Apple กังวลและให้ความสำคัญคือสื่อการแสดงการล่วงละเมิดทางเพศเด็กหรือ Child Sexual Abuse Material (CSMA)

โดยวิธีที่ Apple ใช้ในการสแกน CSMA นั้นจะเป็นการใช้ AI บนอุปกรณ์ที่ใช้งาน iOS 15 หรือ iPadOS 15 ของผู้ใช้งานเองในการสแกนหาภาพหรือวิดีโอที่เข้าข่าย CSMA ก่อนที่จะมีการอัปโหลดไปไว้บน iCloud Photos ไม่ได้แอปเข้าไปสแกนภาพทั้งหมดบน Cloud ของเรา

ซึ่งเมื่อพบรูปภาพที่เกี่ยวข้องกับ CSMA แล้ว Apple ก็จะมีการถอดรหัสภาพเพื่อให้พนักงานที่เป็นมนุษย์จริงๆตรวจสอบอีกครั้งว่ามันเป็นสื่อที่เกี่ยวกับการล่วงละเมิดทางเพศเด็กจริงๆหรือไม่ ก่อนที่จะส่งรายงานไปยังหน่วยงานกลางของสหรัฐฯเพื่อตรวจสอบและบังคับใช้กฏหมายต่อไป

Apple กล่าวว่าด้วยวิธีการใช้ AI ตรวจสอบบนอุปกรณ์ของผู้ใช้เองจะทำให้ผู้ใช้งานจะยังคงมีความเป็นส่วนตัวเหมือนเดิม โดยรูปภาพที่จะถูกตรวจสอบโดยมนุษย์นั้นจะเป็นรูปที่ถูกตรวจว่าเข้าข่าย CSMA แล้วเท่านั้น โดย Apple เคลมว่ามันมีความแม่นยำสูงขนาดที่ผิดพลาดแค่หนึ่งในล้านล้านต่อปีเท่านั้น

อย่างไรก็ตามฟีเจอร์การตรวจจับ CSMA นี้จะไม่ทำงานหากผู้ใช้งานปิดการอัปโหลดรูปไปที่ iCloud Photos

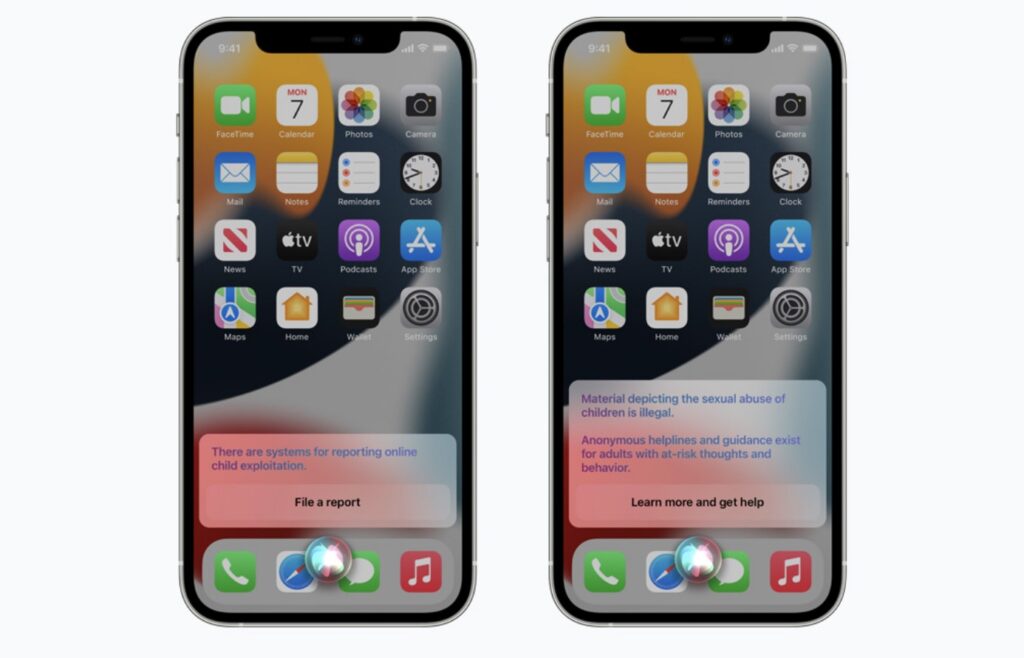

Siri และการค้นหา

นอกจากนี้ Siri และการค้นหาจะถูกอัปเดตใหม่ให้เด็กหรือผู้ปกครองสามารถขอความช่วยเหลือเมื่ออยู่ในสถานการณ์ที่ไม่ปลอดภัยได้ด้วย โดยเมื่อผู้ใช้งานถาม Siri ว่าจะรายงาน CSMA ได้ที่ไหน Siri ก็จะชี้ไปยังเว็ปไซต์หรือแหล่งข้อมูลว่าสามารถส่งรายงานไปที่ใดได้บ้าง

รวมถึง Siri ยังได้รับอัปเดตเพื่อเข้ามาแทรงแซงเมื่อผู้ใช้ทำการค้นหาเนื่อหาที่เกี่ยวข้องกับ CSMA ด้วย โดยการแทรกแซงนี้จะเป็นการอธิบายให้ที่กำลังกระทำการค้นหาสื่อ CSMA ว่าความสนใจของพวกเขาเป็นอันตรายและเป็นปัญหา พร้อมจัดหาแหล่งข้อมูลเพื่อช่วยเหลือในเรื่องดังกล่าวด้วย

และนี้ก็คือคุณสมบัติทั้ง 3 ด้านที่ Apple จะเพิ่มเข้ามาเพื่อปกป้องสิทธิของเด็กๆ โดยมันจะใช้ได้บน iOS 15, iPadOS 15 และ macOS Monterey ที่สหรัฐฯก่อนเป็นอันดับแรกก่อนที่จะขยายออกไปในประเทศอื่นๆ

ข้อมูลเพิ่มเติม – Child Safety – Apple