iOS

ยอมถอย! Apple ประกาศเลื่อนฟีเจอร์สแกนภาพและวีดีโอล่วงละเมิดทางเพศเด็กหลังจากถูกต่อต้านอย่างหนัก

หลังจากที่ถูกกระแสต่อต้านอย่างหนัก Apple ก็ได้เลือนฟีเจอร์การสแกนภาพและวีดีโอล่วงละเมิดทางเพศ (CSAM) ออกไปก่อนแล้วเพื่อศึกษา, รับฟังความคิดเห็นและพัฒนาเพิ่มเติม

By

ก่อนหน้านี้ Apple ประกาศเปิดตัวฟีเจอร์สแกนภาพและวีดีโอล่วงละเมิดทางเพศเด็ก (CSAM) บน iCloud Photos เพื่อปกป้องสิทธ์และรักษาความส่วนตัวของเด็ก แต่ในตอนนี้ Apple ประกาศเลื่อนฟีเจอร์ดังกล่าวแล้วหลังจากถูกกระแสต่อต้านอย่างหนัก

ต้องเกริ่นก่อนว่าเมื่อดูเผินๆแล้วฟีเจอร์นี้ดูจะเป็นฟีเจอร์ที่ดีฟีเจอร์หนึ่งแต่เพราะหลักการทำงานของมันรวมถึง Apple ที่โฆษณาตัวเองว่าเป็นบริษัทที่รักษาความเป็นส่วนตัวของผู้ใช้จึงทำให้มันถูกต่อต้านอย่างหนัก

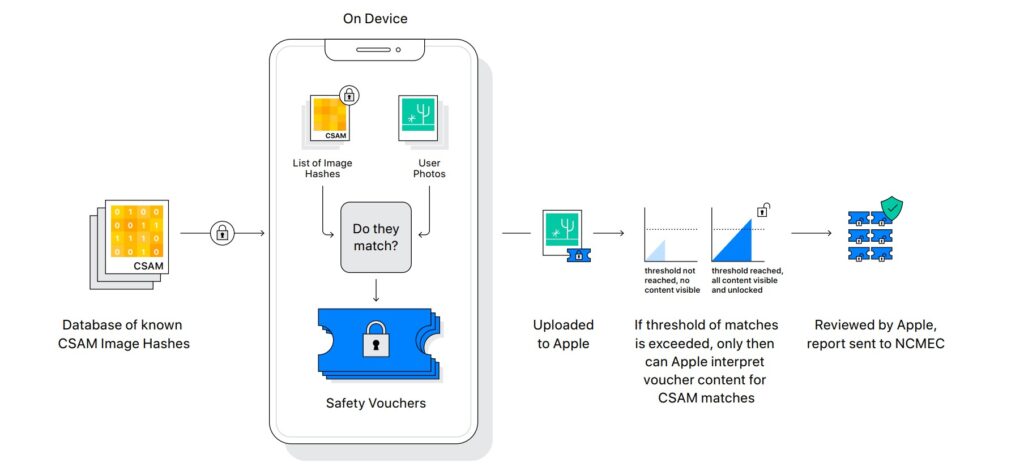

โดยหลักการทำงานของฟีเจอร์นี้ของ Apple จะแตกต่างจากบริษัทอื่นๆที่จะสแกนภาพทุกภาพที่อยู่บนเซิร์ฟเวอร์ Cloud ของบริษัทนั้นๆ แต่ของ Apple จะสแกนรูปภาพที่กำลังจะอัปโหลดขึ้นบน iCloud Photos เพื่อตรวจหาสื่อประเภทนี้โดยใช้การประมวลผลจากตัวเครื่องแทน

ซึ่งแน่นอนแม้จะแตกต่างจากบริษัทอื่นๆเพราะจะทำให้ Apple ไม่เห็นรูปภาพทั้งหมดของผู้ใช้งานแต่จะเห็นเฉพาะรูปที่ตัว iPhone ตั้งธงไว้ว่ามันอาจคือสื่ออนาจารเด็กแต่ผู้ใช้งานก็ไม่พอใจที่ Apple สแกนรูปของพวกเขาอยู่ดี

เพราะเท่ากับ Apple กำลังละเมิดความเป็นส่วนตัวของพวกอยู่ซึ่งเป็นสิ่งที่ Apple พยายามปกป้องมันมาตลอด รวมถึงหลายๆฝ่ายกล่าวว่ามันเป็นวิธีการที่ไม่ได้ผลเอาซะเลยเพราะใครที่มีสื่ออนาจารเด็กอยู่ก็เพียงแค่ปิดการอัปโหลดไปที่ iCloud Photos ก็ไม่โดนตรวจแล้ว

ในความเป็นจริงแล้วทั้ง Google, Facebook, Microsoft และอื่นๆก็มีสแกนรูปภาพบน Cloud ของเราเป็นประจำอยู่แล้วแต่เพราะว่า Apple ที่โฆษณาว่าตังเองรักษาความเป็นส่วนตัวของผู้ใช้งานนั้นจึงโดนกระแสต่อต้านอย่างหนัก

ในตอนแรกฟีเจอร์สแกนภาพและวีดีโอล่วงละเมิดทางเพศเด็กจะเปิดตัวภาพกับ iOS 15, iPadOS 15, macOS Monterey ในช่วงปลายปีนี้ แต่ในตอนนี้ Apple ได้เลื่อนมันออกไปเพื่อศึกษาเกี่ยวกับเรื่องนี้เพิ่มเติมแล้ว

ที่มา – MacRumors